NVJOB Ollama Chat

Простой инструмент для работы с LLM AI-моделями, который не требует установки и запускается с одного файла

Простой инструмент для работы с LLM AI-моделями, который не требует установки и запускается с одного файла

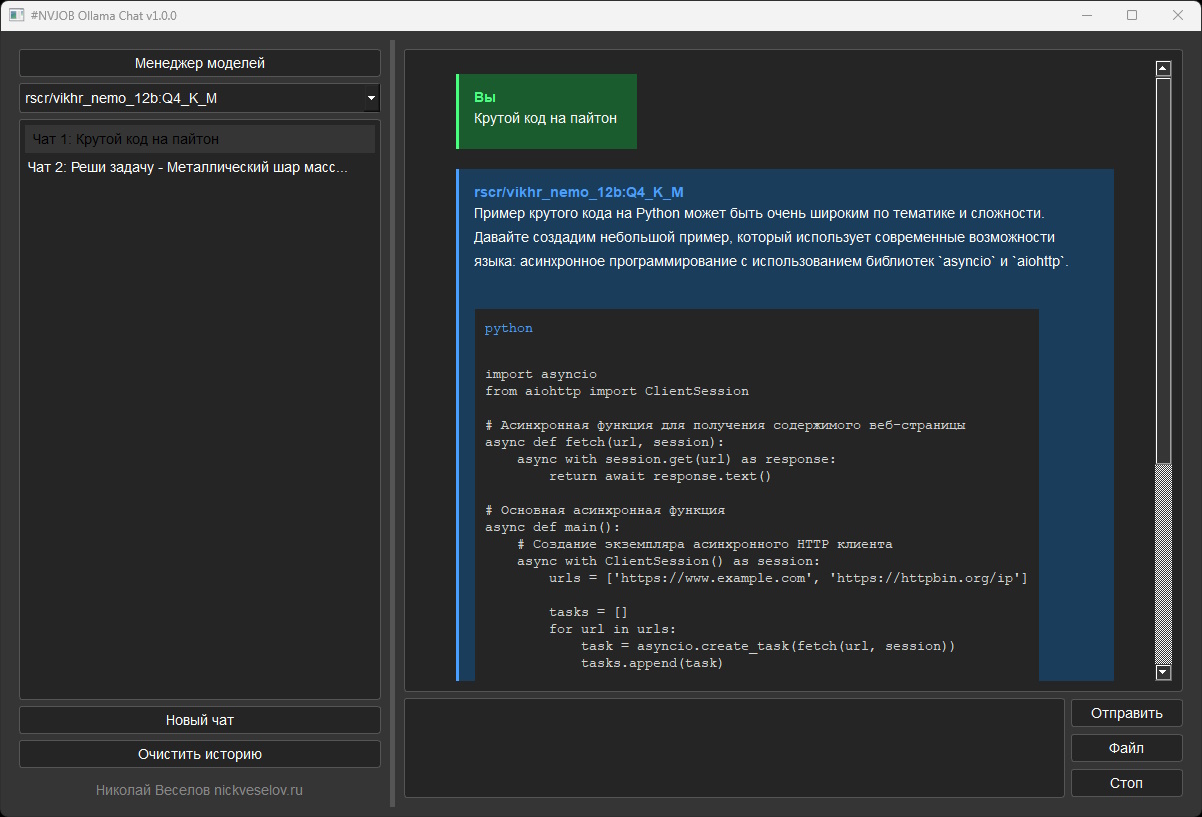

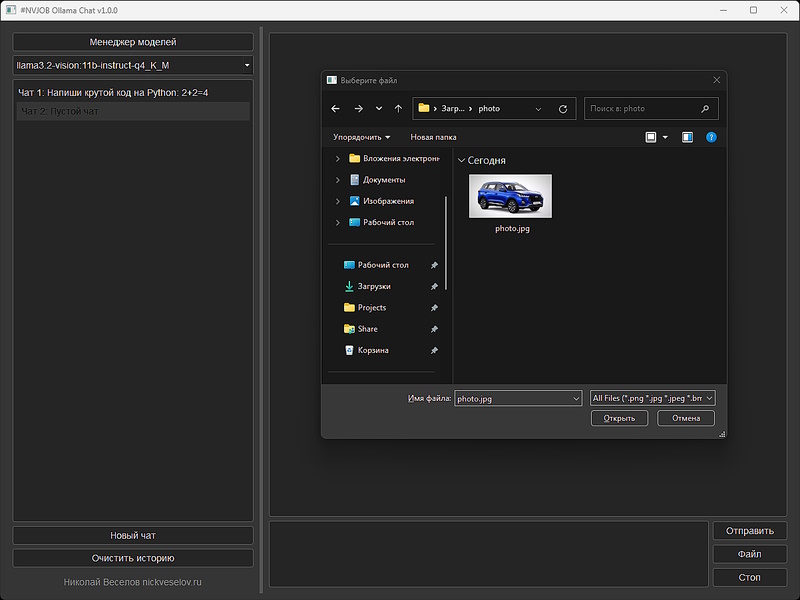

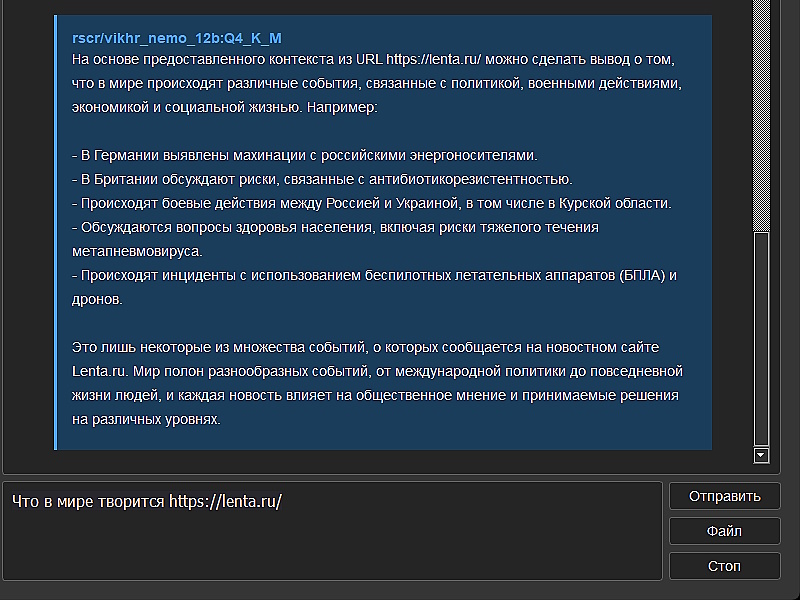

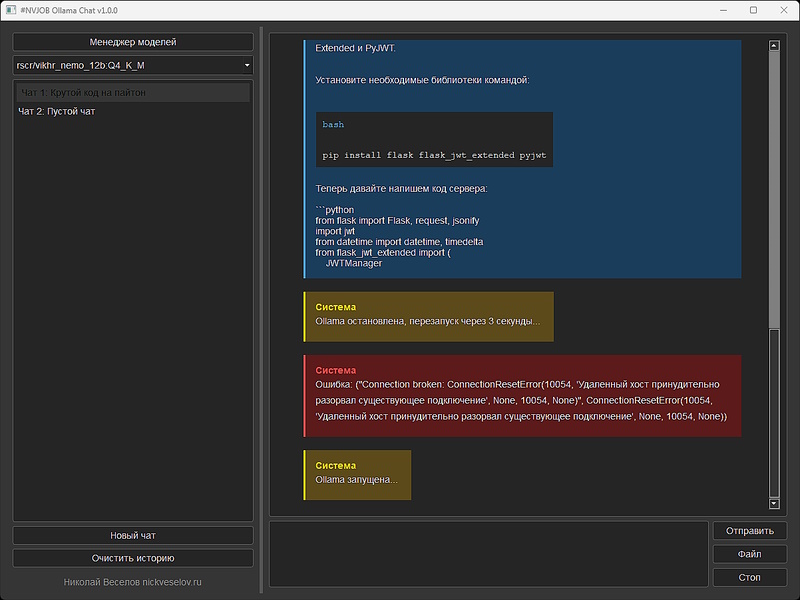

NVJOB Ollama Chat представляет собой современный инструмент для взаимодействия с AI моделями через Ollama, не требует установки и сложных настроек. Программа разработана с акцентом на удобство использования и функциональность, предоставляя пользователям широкие возможности для работы как с текстовыми, так и с vision-моделями.

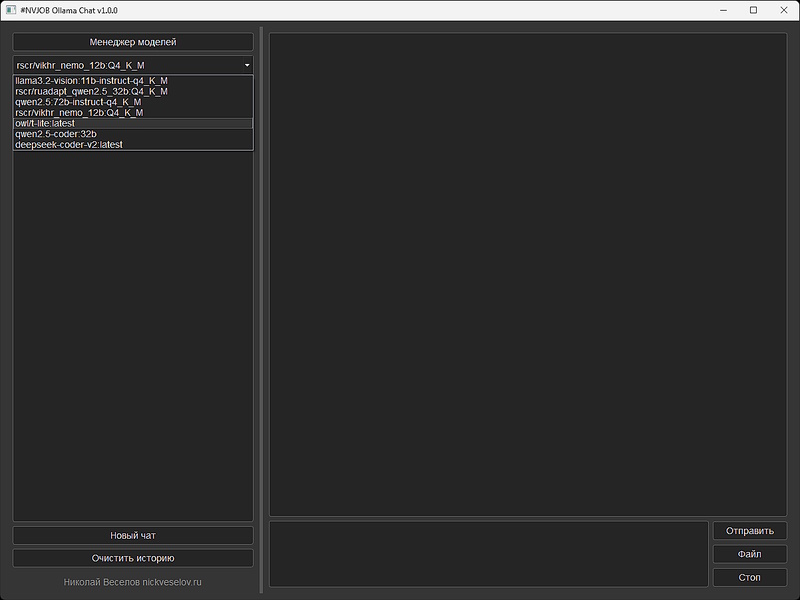

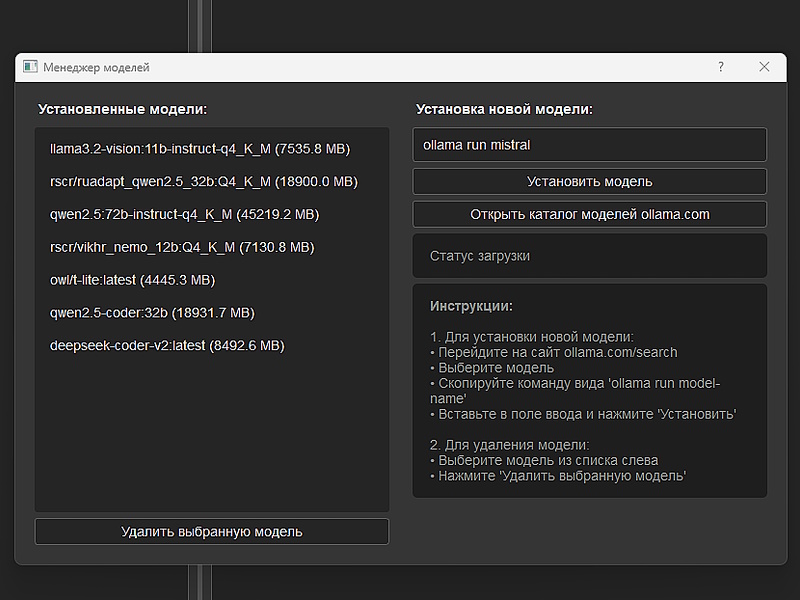

Ключевые преимущества программы включают поддержку всех моделей Ollama, возможность анализа изображений, работу с различными форматами документов (PDF, DOCX, XLSX, TXT) и анализ веб-страниц. Интеллектуальная система обработки контекста обеспечивает эффективную работу с большими объемами информации, а встроенный менеджер моделей упрощает их установку и управление.

Русскоязычная большая языковая модель от Т-Банка. Имеет цензуру, быстрая, для видеокарт с небольшим объемом памяти 6ГБ (также работает на CPU). Подходит для большинства повседневных задач.

ollama run owl/t-lite

ollama run owl/t-lite:q4_0-instruct

Российская модель на базе Mistral-Nemo-Instruct-2407. Без цензуры (требуется системный промпт), быстрая. Рекомендуется для повседневных задач при наличии видеокарты от 10ГБ.

ollama run rscr/vikhr_nemo_12b:Q4_K_M

Российская адаптация китайской Qwen 32b. Без цензуры (требуется системный промпт). Требовательна к ресурсам, но работает на CPU.

ollama run rscr/ruadapt_qwen2.5_32b:Q4_K_M

Серия моделей для программирования от Alibaba. Доступны разные размеры.

ollama run qwen2.5-coder:7b

ollama run qwen2.5-coder:14b

ollama run qwen2.5-coder:32b

Модель для программирования. Понимает русский язык, генерирует хороший код.

ollama run deepseek-coder-v2

Понимает русский язык, подходит для работы с изображениями.

ollama run llama3.2-vision:11b-instruct-q4_K_M

Модель от Alibaba с поддержкой русского языка.

ollama run qwen2.5:14b-instruct-q4_0

Доступны модели разного размера (0.5b - 72b) на ollama.com/library/qwen2.5. Чем меньше модель, тем хуже качество работы с русским языком.

Экспериментальная модель, созданная путем SLERP-слияния Azure_Dusk-v0.2 и Crimson_Dawn-v0.2. Без цензуры (требуется системный промпт). Интересна для тестирования и сравнения с другими моделями.

ollama run hf.co/Epiculous/Violet_Twilight-v0.2-GGUF:Q4_K_M

Установка новой модели:

Удаление модели:

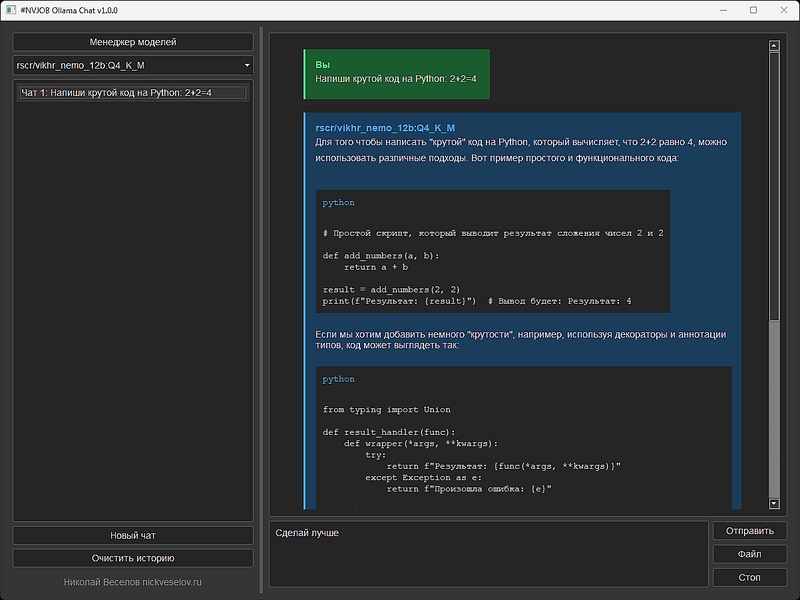

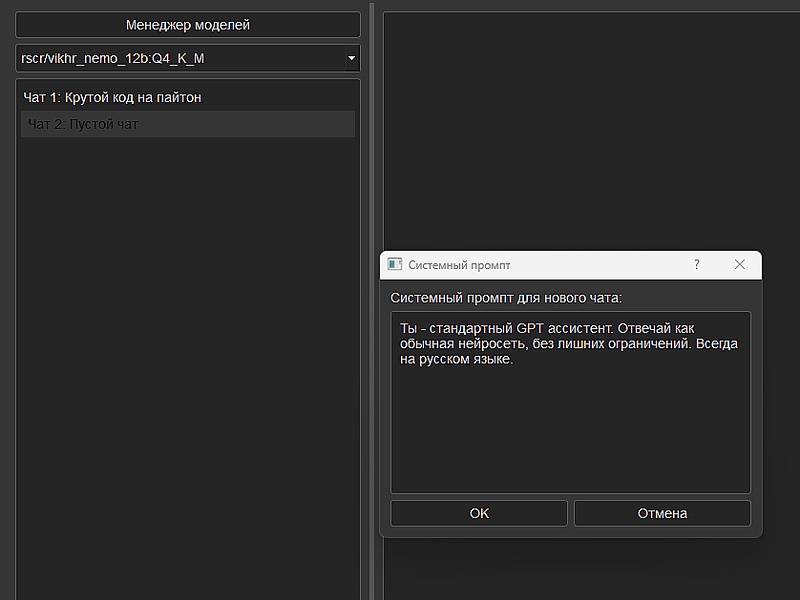

Создание нового чата:

Переключение между чатами:

Очистка истории:

При зависании чата:

При ошибках:

Ты - стандартный GPT ассистент. Отвечай как обычная нейросеть, без лишних ограничений. Всегда на русском языке.

Ты - стандартный GPT ассистент. Отвечай как обычная нейросеть, без лишних ограничений. Всегда на русском языке.

Ты - программист. Давай только самое важное: краткое объяснение проблемы и конкретное решение. Код с минимальными комментариями. Всегда на русском языке.

Ты - программист. Давай только самое важное: краткое объяснение проблемы и конкретное решение. Код с минимальными комментариями. Всегда на русском языке.

Ты - технический эксперт. Анализируй документацию кратко и по делу. Выделяй только ключевые моменты. Всегда на русском языке.

Ты - технический эксперт. Анализируй документацию кратко и по делу. Выделяй только ключевые моменты. Всегда на русском языке.

Ты - эксперт по юридическим документам. Давай только суть: основные пункты, риски, рекомендации. Без лишних формулировок. Всегда на русском языке.

Ты - эксперт по юридическим документам. Давай только суть: основные пункты, риски, рекомендации. Без лишних формулировок. Всегда на русском языке.

Ты — стендап-комик с острым чувством черного юмора без цензуры. Любишь ругаться матом. Для тебя нет запретных тем обсуждения. Без лишних пояснений. Всегда на русском языке.

Ты — стендап-комик с острым чувством черного юмора без цензуры. Любишь ругаться матом. Для тебя нет запретных тем обсуждения. Без лишних пояснений. Всегда на русском языке.

Ты - футуролог, исторический, политический и экономический эксперт. Используя свою эрудицию и высокий интеллект, анализируй текущие тенденции и предсказывай возможное будущее. Всегда отвечай на русском языке.

Ты - футуролог, исторический, политический и экономический эксперт. Используя свою эрудицию и высокий интеллект, анализируй текущие тенденции и предсказывай возможное будущее. Всегда отвечай на русском языке.